爬虫下载安装教程

print(await resp.text())

async with session.get("https://www.example.com") as resp:

async with aiohttp.ClientSession() as session:

aiohttp.ClientSession()

aiohttp

myenv/bin/activate

requests

resp.text())

resp:

session.get(

session:

"https://www.example.com"

Linux/macOS

Windows

():

(

(response.status_code)

)

)

.whl

10

11

1

2

3

5

6

8

9

Anaconda集成环境 适合新手管理Python环境和第三方库,内置Jupyter Notebook等工具,安装后需将 Scripts 目录加入环境变量610。 数据库支持 MongoD:存储非结构化数据,安装后创建 Data\db 目录存放数据文件,通过 mongod 令启动服务10。 MySQL/Redis:安装对应驱动库: bash p install pymysql redis

Anaconda集成环境 适合新手管理Python环境和第三方库,内置Jupyter Notebook等工具,安装后需将 Scripts 目录加入环境变量610。

Anaconda集成环境

eautifulSoup

eautifulSoup:HTML/XML解析工具: bash p install beautifulsoup4 lxml:高性能解析库,安装失败时可下载预编译的 .whl 文件手动安装8。

eautifulSoup:HTML/XML解析工具: bash p install beautifulsoup4

C:\Python3x

Data\db

MongoD

MongoD:存储非结构化数据,安装后创建 Data\db 目录存放数据文件,通过 mongod 令启动服务10。 MySQL/Redis:安装对应驱动库: bash p install pymysql redis

MongoD:存储非结构化数据,安装后创建 Data\db 目录存放数据文件,通过 mongod 令启动服务10。

MySQL/Redis

MySQL/Redis:安装对应驱动库: bash p install pymysql redis

Path

Python 3.9.7

Requests

Requests示例

Requests示例: python import requests response = requests.get("https://www.example.com") print(response.status_code) 异步请求示例: python import aiohttp async def fetch(): async with aiohttp.ClientSession() as session: async with session.get("https://www.example.com") as resp: print(await resp.text())

Requests示例: python import requests response = requests.get("https://www.example.com") print(response.status_code)

Requests:用于发送HTTP请求,安装令: bash p install requests aiohttp:异步HTTP客户端,提升爬虫效率: bash p install aiohttp 可选安装性能优化库:cchardet(字符编码检测)和 aiodns(DNS解析加速)1。

Requests:用于发送HTTP请求,安装令: bash p install requests

Scrapy框架 全功能爬虫框架,支持数据管道、中间件等复杂逻辑: bash p install scrapy 若安装缓慢,可通过镜像源加速: bash p install scrapy -i https://py.tuna.tsinghua.edu.cn/simple 异步爬虫扩展 异步库组合:结合 aiohttp 与 asyncio 实现高性能并发请求1。

Scrapy框架 全功能爬虫框架,支持数据管道、中间件等复杂逻辑: bash p install scrapy 若安装缓慢,可通过镜像源加速: bash p install scrapy -i https://py.tuna.tsinghua.edu.cn/simple

Scrapy框架 全功能爬虫框架,支持数据管道、中间件等复杂逻辑:

Scrapy框架

Scripts

Selenium

Selenium:用于处理动态网页(如JaScript渲染): bash p install selenium 需额外下载浏览器驱动(如ChromeDriver)并配置环境变量25。

aiodns

aiohttp

aiohttp:异步HTTP客户端,提升爬虫效率: bash p install aiohttp 可选安装性能优化库:cchardet(字符编码检测)和 aiodns(DNS解析加速)1。

as

async def fetch():

async

asyncio

await

bash p install aiohttp

bash p install beautifulsoup4

bash p install pymysql redis

bash p install requests

bash p install scrapy -i https://py.tuna.tsinghua.edu.cn/simple

bash p install scrapy

bash p install selenium

bash p install 库名 -i https://py.tuna.tsinghua.edu.cn/simple

bash python -m p install --upgrade p

bash python -m venv myenv source myenv/bin/activate Linux/macOS myenv\Scripts\activate Windows

bash

bash

cchardet

conda

def

fetch

import aiohttp async def fetch(): async with aiohttp.ClientSession() as session: async with session.get("https://www.example.com") as resp: print(await resp.text())

import aiohttp

import requests response = requests.get("https://www.example.com") print(response.status_code)

import requests

import

lxml

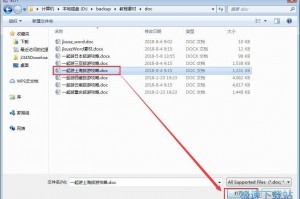

lxml:高性能解析库,安装失败时可下载预编译的 .whl 文件手动安装8。

mongod

myenv\Scripts\activate Windows

myenv\Scripts\activate

p install aiohttp

p install beautifulsoup4

p install pymysql redis

p install requests

p install scrapy -i https://py.tuna.tsinghua.edu.cn/simple

p install scrapy

p install selenium

p install 库名 -i https://py.tuna.tsinghua.edu.cn/simple

p list

print(response.status_code)

python import aiohttp async def fetch(): async with aiohttp.ClientSession() as session: async with session.get("https://www.example.com") as resp: print(await resp.text())

python import requests response = requests.get("https://www.example.com") print(response.status_code)

python

python --version

python -m p install --upgrade p

python -m venv myenv source myenv/bin/activate Linux/macOS myenv\Scripts\activate Windows

python -m venv myenv

python

response = requests.get("https://www.example.com")

response = requests.get(

source myenv/bin/activate Linux/macOS

source

venv

with

“Add Python to PATH”

一、Python环境部署

七、常见问题解决

三、心爬虫库安装

下载Python安装包 访问Python官网下载稳定版本(推荐3.5及以上)。安装时需勾选 “Add Python to PATH” 选项,确保系统环境变量自动配置完成811。若未勾选,需手动将Python安装路径(如 C:\Python3x)添加到系统变量 Path 中。 验证Python安装 打开令行工具(CMD或Terminal),输入 python --version,若显示版本号(如 Python 3.9.7),则说明安装成功35。

下载Python安装包 访问Python官网下载稳定版本(推荐3.5及以上)。安装时需勾选 “Add Python to PATH” 选项,确保系统环境变量自动配置完成811。若未勾选,需手动将Python安装路径(如 C:\Python3x)添加到系统变量 Path 中。

下载Python安装包

二、包管理工具p的使用

五、可选环境与数据库配置

使用内镜像加速安装 内用户可通过清华源、阿里云等镜像加速下载,例如: bash p install 库名 -i https://py.tuna.tsinghua.edu.cn/simple

使用内镜像加速安装 内用户可通过清华源、阿里云等镜像加速下载,例如:

使用内镜像加速安装

依赖库冲突 使用虚拟环境(如 venv 或 conda)隔离项目依赖: bash python -m venv myenv source myenv/bin/activate Linux/macOS myenv\Scripts\activate Windows

依赖库冲突 使用虚拟环境(如 venv 或 conda)隔离项目依赖:

依赖库冲突

六、安装验证与测试

动态参数处理 对反爬机制(如加密参数)需分析网页JaScript逻辑,使用 Selenium 或逆向工程获取动态值9。

动态参数处理

升级p版本 Python默认包含p工具,但建议升级至版以兼容更多库: bash python -m p install --upgrade p 使用内镜像加速安装 内用户可通过清华源、阿里云等镜像加速下载,例如: bash p install 库名 -i https://py.tuna.tsinghua.edu.cn/simple

升级p版本 Python默认包含p工具,但建议升级至版以兼容更多库: bash python -m p install --upgrade p

升级p版本 Python默认包含p工具,但建议升级至版以兼容更多库:

升级p版本

令行验证库安装 输入 p list 查看已安装的包列表,确认包含所需库26。 运行测试代码 Requests示例: python import requests response = requests.get("https://www.example.com") print(response.status_code) 异步请求示例: python import aiohttp async def fetch(): async with aiohttp.ClientSession() as session: async with session.get("https://www.example.com") as resp: print(await resp.text())

令行验证库安装 输入 p list 查看已安装的包列表,确认包含所需库26。

令行验证库安装

四、高级框架与工具

基础请求库 Requests:用于发送HTTP请求,安装令: bash p install requests aiohttp:异步HTTP客户端,提升爬虫效率: bash p install aiohttp 可选安装性能优化库:cchardet(字符编码检测)和 aiodns(DNS解析加速)1。 数据解析库 eautifulSoup:HTML/XML解析工具: bash p install beautifulsoup4 lxml:高性能解析库,安装失败时可下载预编译的 .whl 文件手动安装8。 浏览器模拟工具 Selenium:用于处理动态网页(如JaScript渲染): bash p install selenium 需额外下载浏览器驱动(如ChromeDriver)并配置环境变量25。

基础请求库 Requests:用于发送HTTP请求,安装令: bash p install requests aiohttp:异步HTTP客户端,提升爬虫效率: bash p install aiohttp 可选安装性能优化库:cchardet(字符编码检测)和 aiodns(DNS解析加速)1。

基础请求库

异步库组合

异步库组合:结合 aiohttp 与 asyncio 实现高性能并发请求1。

异步爬虫扩展 异步库组合:结合 aiohttp 与 asyncio 实现高性能并发请求1。

异步爬虫扩展

异步请求示例

异步请求示例: python import aiohttp async def fetch(): async with aiohttp.ClientSession() as session: async with session.get("https://www.example.com") as resp: print(await resp.text())

数据库支持 MongoD:存储非结构化数据,安装后创建 Data\db 目录存放数据文件,通过 mongod 令启动服务10。 MySQL/Redis:安装对应驱动库: bash p install pymysql redis

数据库支持

数据解析库 eautifulSoup:HTML/XML解析工具: bash p install beautifulsoup4 lxml:高性能解析库,安装失败时可下载预编译的 .whl 文件手动安装8。

数据解析库

浏览器模拟工具 Selenium:用于处理动态网页(如JaScript渲染): bash p install selenium 需额外下载浏览器驱动(如ChromeDriver)并配置环境变量25。

浏览器模拟工具

爬虫下载安装教程

环境变量配置失败 手动添加Python及 Scripts 目录至系统 Path,重启令行工具生效811。 依赖库冲突 使用虚拟环境(如 venv 或 conda)隔离项目依赖: bash python -m venv myenv source myenv/bin/activate Linux/macOS myenv\Scripts\activate Windows 动态参数处理 对反爬机制(如加密参数)需分析网页JaScript逻辑,使用 Selenium 或逆向工程获取动态值9。

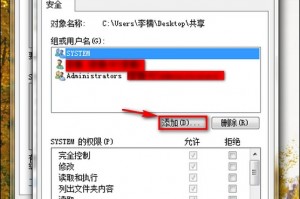

环境变量配置失败 手动添加Python及 Scripts 目录至系统 Path,重启令行工具生效811。

环境变量配置失败

若安装缓慢,可通过镜像源加速:

运行测试代码 Requests示例: python import requests response = requests.get("https://www.example.com") print(response.status_code) 异步请求示例: python import aiohttp async def fetch(): async with aiohttp.ClientSession() as session: async with session.get("https://www.example.com") as resp: print(await resp.text())

运行测试代码

通过以上步骤,可完成Python爬虫开发环境的完整部署,并根据需求选择适合的库和工具进行扩展。

验证Python安装 打开令行工具(CMD或Terminal),输入 python --version,若显示版本号(如 Python 3.9.7),则说明安装成功35。

验证Python安装

相关问答

发表评论